https://arxiv.org/pdf/1503.02531.pdf

- Knowledge distillation 은 미리 학습시킨 Teacher network 의 출력을 내가 실제로 사용하고자 하는 작은 모델인 Student network 가 모방하여 학습함으로써, 상대적으로 적은 Parameter 를 가지고 있더라도 모델의 성능을 높이는 방법론입니다.

Knowledge-Distillation은 Teacher Network로부터 Student Network를 학습시키는 모델로 Teacher-Student Network로 언급되기도 합니다. 학습하고자 하는 Dataset D가 있을 때 Teacher Network T가 Dataset D를 먼저 학습합니다. 그 후 Teacher Network보다 작은 규모의 Student Network S가 Teacher Network T를 활용하여 Dataset D를 학습합니다. 이 과정을 Distillation이라는 용어로 표현하는데, 이는 Teacher Network T가 Student Network S에게 Dataset D에 관한 지식을 응축하여 전달하는 것이라고 할 수 있습니다. 이렇게 학습된 Student Network S는 Teacher Network T 없이 Dataset D를 직접 학습한 S’보다 더 높은 성능을 보인다는 것이 여러 논문을 통해 확인되었습니다. 이것은 보다 큰 Neural Network인 Teacher Network T의 지식이 작은 Neural Network인 Student Network S로 Distillation 되었다고 하여 Knowledge-Distillation이라고 합니다. T의 지식을 S로 어떻게 전달할 것인가에 대해 2015년 Geoffrey Hinton 교수가 발표한 ‘Distilling the Knowledge in a Neural Network’을 비롯하여 다양한 연구가 진행되고 있습니다.

- knowledge transfer, knowledge distillation, transfer learning 차이는?

- Knowledge Transfer은 크게 Knowledge Distillation과 Transfer Learning으로 구분 가능

- Transfer Learning은 서로 다른 도메인에서 지식을 전달하는 방식

- Knowledge Distillation은 같은 도메인 내 모델 A에게 모델 B가 지식을 전달하는 방식 (Model Compression 효과)

- Knowledge Transfer은 크게 Knowledge Distillation과 Transfer Learning으로 구분 가능

- KD는 Model Compression이라는 측면에서 다양하게 사용할 수 있음

- BERT와 같은 무거운 모델을 경량화하기 위해 KD를 사용

https://light-tree.tistory.com/196

딥러닝 용어 정리, Knowledge distillation 설명과 이해

이 글은 제가 공부한 내용을 정리하는 글입니다. 따라서 잘못된 내용이 있을 수도 있습니다. 잘못된 내용을 발견하신다면 리플로 알려주시길 부탁드립니다. 감사합니다. Knowledge distillation 이란?

light-tree.tistory.com

https://baeseongsu.github.io/posts/knowledge-distillation/

딥러닝 모델 지식의 증류기법, Knowledge Distillation

A minimal, portfolio, sidebar, bootstrap Jekyll theme with responsive web design and focuses on text presentation.

baeseongsu.github.io

'딥러닝 이론' 카테고리의 다른 글

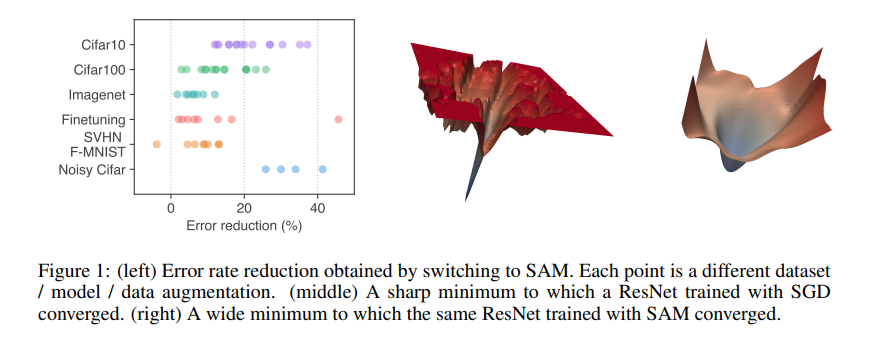

| Loss landscape / Flat Minima & Sharp Minima (1) | 2022.10.04 |

|---|---|

| AutoEncoder (0) | 2022.08.24 |

| Meta Learning (0) | 2022.08.22 |

| *NAS(neural architecture search) (0) | 2022.07.28 |

| *Transformer (0) | 2022.07.06 |